Hbase集群安装 服务器规划

IP

域名

系统版本号

10.10.x.70

zk.had01

Linux version 5.4.0-70-generic (buildd@lcy01-amd64-004) (gcc version 9.3.0 (Ubuntu 9.3.0-17ubuntu1~20.04)) #78-Ubuntu SMP Fri Mar 19 13:29:52 UTC 2021

10.10.x.8

zk.had02

Linux version 5.4.0-70-generic (buildd@lcy01-amd64-004) (gcc version 9.3.0 (Ubuntu 9.3.0-17ubuntu1~20.04)) #78-Ubuntu SMP Fri Mar 19 13:29:52 UTC 2021

10.187.x.120

zk.had03

Linux version 3.10.0-957.el7.x86_64 (mockbuild@kbuilder.bsys.centos.org ) (gcc version 4.8.5 20150623 (Red Hat 4.8.5-36) (GCC) ) #1 SMP Thu Nov 8 23:39:32 UTC 2018

环境要求

host文件 将本地回环地址改成内网地址(hbase需要), 将规划的域名zk.had01, zk.had02, zk.had03的配置如下:

10.10.27.70机器的host配置:

1 2 3 4 5 6 7 8 9 10 11 12 13 root@GT70:~# cat /etc/hosts127 .0 .0 .1 localhost10.10.27.70 GT70127.0.0.1 localhost1 ip6-localhost ip6-loopback0 ip6-localnet0 ip6-mcastprefix1 ip6-allnodes2 ip6-allrouters10.10.27.70 zk.had0110.10.27.8 zk.had0210.187.100.120 zk.had03

10.10.27.8机器的host配置:

1 2 3 4 5 6 7 8 9 10 11 12 13 hadoop@root-RiskCtrl:/opt/hbase234/logs$ cat /etc/hosts10.10.27.8 root-RiskCtrl127.0.0.1 localhost1 ip6-localhost ip6-loopback0 ip6-localnet0 ip6-mcastprefix1 ip6-allnodes2 ip6-allrouters10.10.27.70 zk.had01 GT70 master10.10.27.8 zk.had02 root-RiskCtrl10.187.100.120 zk.had03 selenium-test

10.187.100.120机器的host配置:

1 2 3 4 5 6 7 8 9 10 [hadoop@selenium-test hadoop] $ cat /etc/hosts10.187.100.120 selenium-test127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain41 localhost localhost.localdomain localhost6 localhost6.localdomain610.5.28.240 riskmg-dev.gtland.cn10.5.28.240 authcctr-dev.gtland.cn10.10.27.70 zk.had0110.10.27.8 zk.had02 root-RiskCtrl10.187.100.120 zk.had0310.10.27.70 GT70 master

用户及用户组 用户组、用户、权限规划

用户组

用户

权限

hadoop

hadoop

/opt/hadoop-2.10-1

新建用户组hadoop

新建hadoop用户

1 useradd hadoop -g hadoop -m -s /bin/ bash

给已创建的用户hadoop设置密码为hadoop

修改目录所属用户

1 2 chown -R hadoop.hadoop /opt/hadoop-2.10.1chown -R hadoop.hadoop /opt/hbase234

切换用户hadoop

Note:

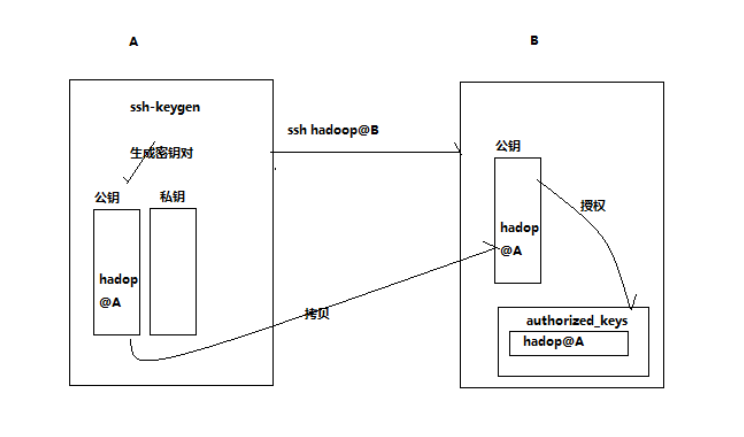

免密登录 方式一:

1 2 3 4 ssh-keygencopy -id -p 22612 hadoop@zk.had01copy -id -p 22612 hadoop@zk.had02copy -id -p 22612 hadoop@zk.had03

方式二:

将本机的公钥文件上传到目标服务器上,然后在服务器需要免密登录的用户家目录下查看是否有 ~/.ssh/authorized_keys这个文件,

1 touch ~/.ssh/authorized_keys

然后我们将公钥内容写入到authorized_keys文件中,因为这个文件可能已经有内容了,所以你可以使用如下方式

1 cat -n ~/.ssh/rsa.pub ~/.ssh/authorized_keys

这样就将公钥内容追加到authorized_keys中了,然后需要注意配置权限了,否则SSH不会工作的.

将.ssh目录的权限为700

设置别名:

内容如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 host hadoop1user hadoop 10.10 .27.70 22612 user hadoop 10.10 .27.8 22612 user hadoop 10.187 .100.120 22612

下载Hbase 1 2 cd /optwget http://mirrors.hust.edu.cn/apache/hbase/stable/hbase-2 .3 .4 -bin.tar.gz

解压 1 tar -zxvf hbase-2 .3 .4 -bin.tar.gz

修改配置文件 修改hbase-env.sh:

1 2 cd hbase-2.3 .4 /conf vi hbase-env.sh

1 2 export JAVA_HOME =/usr/local/jdk1.8.0_73export HBASE_MANAGES_ZK =false

修改hbase-site.xml:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 <configuration > <property > <name > hbase.cluster.distributed</name > <value > true</value > </property > <property > <name > hbase.zookeeper.quorum</name > <value > zk.had01:2181,zk.had02:2181,zk.had03:2181</value > </property > <property > <name > hbase.rootdir</name > <value > hdfs://zk.had01:9000/hbase234</value > </property > <property > <name > hbase.zookeeper.property.dataDir</name > <value > /data/hbase/zookeeper</value > </property > <property > <name > hbase.master.info.port</name > <value > 16610</value > </property > </configuration >

修改regionservers:

修改backup-masters:

修改hdfs-site.xml 和 core-site.xml:

1 2 cd /opt/hadoop-2 .10 .1 /etc/hadoopcp core-site.xml hdfs-site.xml /opt/hbase-2 .3 .4 /conf/

将Hbase安装包分发到其他节点 分发之前先删除HBase目录下的docs文件夹

1 2 cd /opt/hbase-2 .3 .4 /rm -rf docs

分发

1 2 scp -r hbase-2 .3 .4 / hadoop@zk.had02:/tmpscp -r hbase-2 .3 .4 / hadoop@zk.had03:/tmp

分别登陆zk.had02, zk.had03,移动hbase-2.3.4至/opt下

1 mv /tmp/hbase-2 .3 .4 /opt

同步时间 HBase 集群对于时间的同步要求的比 HDFS 严格,所以,集群启动之前千万记住要进行 时间同步,要求相差不要超过 30s

配置环境变量 内容如下:

1 2 3 export HBASE_HOME =/opt/hbase-2.3.4/export PATH =$PATH :$HBASE_HOME/bin

使环境变量立即生效

启动Hbase集群 启动zookeeper集群 每个zookeeper节点都要执行以下命令

启动HDFS集群及YARN集群 1 2 cd /opt/hadoop-2.10.1/sbin

启动HBase 1 2 cd /opt/hbase-2.3.4/bin

巨人的肩膀